La DSI est confrontée à beaucoup d’offres de stockage lorsqu’il s’agit de répondre à une demande de capacité ou de performance. Finalement cela aboutit à de l’hétérogénéité au niveau du matériel de stockage, en fonction des opportunités plus ou moins intéressantes présentées par les constructeurs successifs. Alors qu’au final, il faut se rendre indépendant du matériel. C’est le sens de l’histoire de l’informatique.

Après la virtualisation de l’espace de travail utilisateur (application, bureau, O/S) et des charges applicatives sur les serveurs (hyperviseurs), il est logique d’ajouter une couche d’abstraction analogue pour organiser son stockage et banaliser le matériel. Bien que DataCore se soit construit sur ce concept depuis plusieurs années, le discours de banalisation du matériel de stockage reste encore aujourd’hui différenciant et novateur dans une industrie dominée par la vente de baies. Les intégrateurs qui vont dans ce sens répondent non seulement au besoin mais ouvrent également de nouvelles perspectives pour leurs clients.

Organiser le stockage plutôt que planifier

Le Software-defined storage ou stockage à base logicielle permet tout simplement de décorréler la gestion du stockage dans le but de banaliser le matériel.

- Différents périphériques de stockage doivent pouvoir parler entre eux

- On dissocie les évolutions logicielles et matérielles

- Toutes les capacités de stockage sont regroupées au sein d’une gestion centralisée (pour éviter la multi-compétence)

- Très important ! On facilite la maintenance et le renouvellement du matériel, et la migration de données

Ce dernier point nous amène à un aspect très intéressant dans la mesure où il s’agit de changer la vision qu’a la DSI de la manière d’envisager le stockage dans les plans pluri-annuels qu’elle établit et présente à la direction. On répondra certes indirectement au besoin premier mais on doit surtout déclencher une prise de conscience du besoin sous-jacent de continuité d’activité et de la disponibilité du stockage. Au final le besoin n’est pas tant d’évaluer la capacité de stockage à prévoir à moyen ou long terme que d’organiser son stockage pour prendre en compte l’imprévu sans sortir de son plan et éviter de provisionner trop ou trop peu de budget.

Prévoir les besoins en stockage dans les années à venir à l’échelle d’une entreprise est très risquée. Surprovisionner risque de pénaliser les autres budgets et notamment les nécessaires investissements en sécurité. Demander des budgets supplémentaires en cours de route place le responsable informatique sur la sellette. Le software-defined storage lui permet à l’inverse de répondre à toute évolution inattendue dans le cadre du plan informatique : maintenance, renouvellement de matériel, augmentation de données...

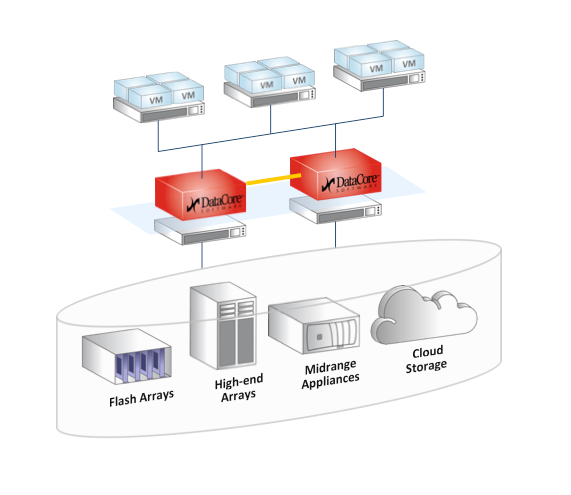

En choisissant Datacore, je mets en place un cluster de serveurs équipés du logiciel SANsymphony-V, auquel vont se connecter toutes les charges applicatives (hyperviseurs avec VMs, serveurs physiques…). On va permettre à l’ensemble de ces applications, de ces serveurs, de voir un pool de stockage, un espace de stockage unique virtuel et complètement sécurisé. On garantit qu’il n’y aura jamais de rupture d’accès aux données. C’est d'autant plus critique désormais, puisque les VMs n’ont pas de stockage local. Si le stockage est inaccessible, plus rien ne fonctionne. La virtualisation des serveurs a conduit à cette centralisation qui exige absolument une haute disponibilité.

Se libérer du matériel. Se libérer d’une marque de stockage

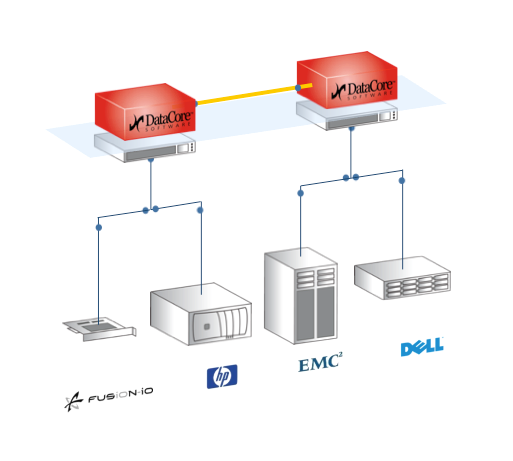

Ce qui sera vu comme un stockage unique peut être la somme de n solutions de stockage différentes agrégées. Pour ajouter de la capacité pour répondre à une évolution nécessaire mais non-prévue, on peut bien entendu ajouter des disques dans la baie en place si c’est possible. Mais si on a dimensionner au plus juste notre baie au départ, il va falloir changer la baie complète pour une nouvelle de plus grande capacité. Ou acheter une petite baie à côté, mais qui communiquera mal avec l’équipement principal (réplication, transfert de données).

En virtualisant mon stockage, aucune rupture de service n’intervient plus. J’ajoute le stockage que je veux. Le cluster logiciel unifie tout, et prend donc en compte ce nouveau stockage pour augmenter la capacité virtuelle globale à présenter aux applications. Sans DataCore, tout ajout de capacité expose au risque d’avoir à acheter au prix fort du disque supplémentaire chez le constructeur puisqu’on est tenu par le choix de baie initial. Tous les DSI rencontrés ont été confrontés à cette situation. Se libérer de cette contrainte permet de remettre en concurrence les fournisseurs à chaque fois et donc de payer son stockage au meilleur prix tout au long du plan pluri-annuel. On fait ainsi face avec beaucoup plus de sérennité à toutes les évolutions inattendues au cours du plan informatique.

Et à la fin du plan, pour faire face au nouveau plan à établir et aux nouvelles capacités attendues, sans Datacore, il faut enlever l’existant et reprendre des baies adaptées. Au final DataCore propose non seulement de parer à toute éventualité pendant le plan informatique à venir ou en cours mais également de préparer dès à présent la suite du présent plan, puisqu’on garde toute l’intelligence et les fonctionnalités mises en place -Il suffit juste de renouveler la maintenance logicielle associée. Les capacités devant être ajoutées seront une nouvelle fois négociées au meilleur prix.

Le vrai besoin : la continuité de service des données

Un projet de PCA (Plan de continuité d’activité) n’est pas forcément formalisé, exprimé. La DSI doit prendre conscience que c’est l’organisation de son stockage qui doit être revue, comme cela a été fait pour les serveurs ou les applications. Si l’on cherche à améliorer son stockage, c’est cette approche qu’il faut adopter.

Le coût au tera ne sera peut-être pas plus avantageux à l’achat que celui de nouvelles baies puisque les constructeurs sauront présenter leur meilleur prix au moment de l’achat initial. Mais il est évident que les économies générées en termes de coût de possession, de coûts des évolutions inattendues et du renouvellement planifié seront significatives et aboutiront à une baisse très importante du coût au tera à moyen et long terme.

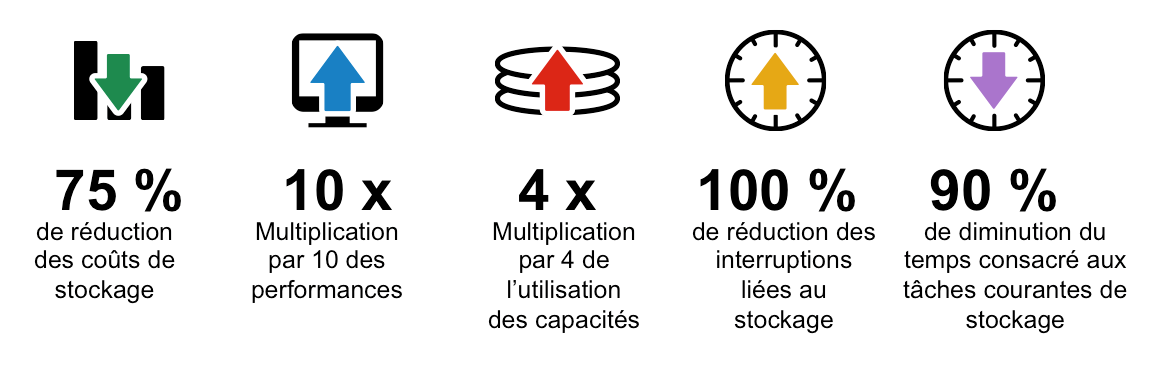

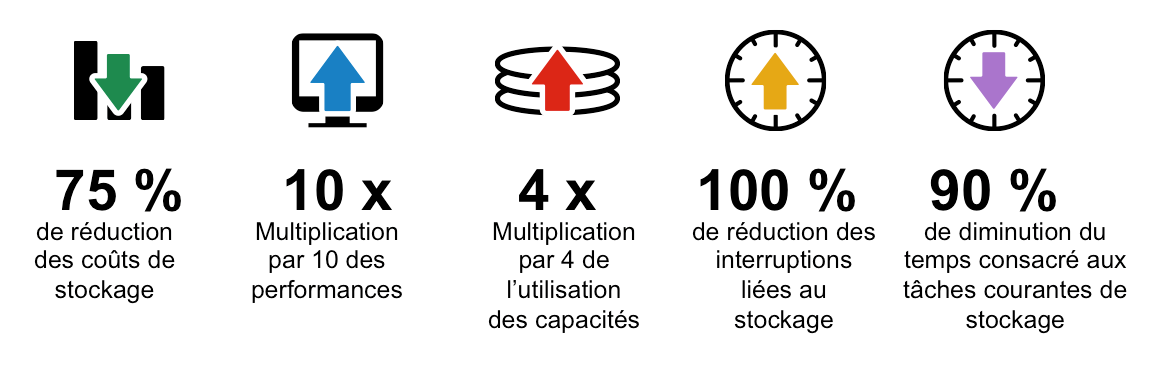

Le cabinet Techvalidate a été mandaté par DataCore pour interroger ses clients existants. Les résultats du sondage montrent de nets bénéfices ressentis en matière de coût de stockage, de performance, de capacité, de continuité et de maintenance :

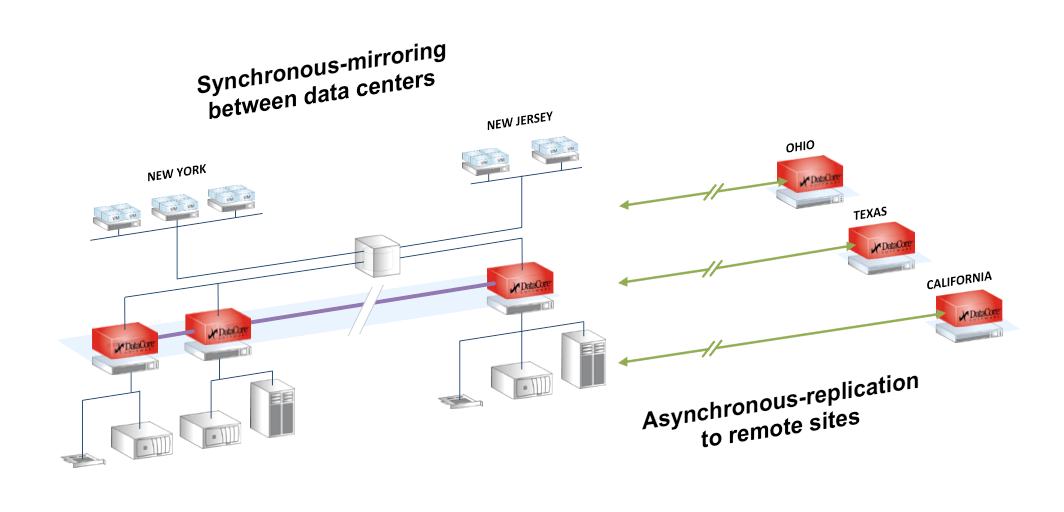

SANsymphony-V de DataCore permet d’organiser deux environnements de stockage de même volumétrie exactement en miroir. La données est écrite en même temps aux deux endroits dans des unités de stockage sur un même site ou sur un site distant relié par de la fibre par exemple. Sans entrer dans les mécanismes techniques, il n’y a que trois ou quatre autres acteurs, tous constructeurs de baies, qui proposent une solution du même ordre, mais en se cantonnant à leur monde propriétaire. DataCore est désormais la seule offre logicielle indépendante et tout DSI convaincu par la nécessité de basculer vers le software-defined storage doit étudier cette solution.

Quand on interroge sur les projets de stockage conduits dans les entreprises, c’est la mise en place d’un PRA (Plan de Reprise d’Activité) qui est la plus citée. Mais en fait c’est du PCA dont l’entreprise a réellement besoin. Et c’est le même prix chez Datacore : le software-defined storage laisse les mains libres pour aider à envisager un PRA et garantit surtout la continuité de l’accès aux données dont ont besoin les applications. Ce sont en effet les ruptures de service qui sont le plus dommageables en termes économiques pour la société et en termes de crédibilité pour le service informatique. Dans 99,9% des cas, ce sont des sinistres mineurs qui gâchent la vie du SI : problèmes d’alimentation, de climatisation ou erreurs de manipulation. Ou des besoins de maintenance qui nécessitent l’arrêt momentané de service. C’est le PCA qui permet de garantir malgré tout la continuité du service. Pas le PRA. Par analogie avec l’achat d’une voiture, on sera réticent à acheter la plus belle voiture si le vendeur précise qu’une fois par an, elle s’arrêtera de fonctionner pendant 1 heure, sans qu’on sache quand. Ce qu’on veut c’est qu’elle ne s’arrête jamais. Le PRA ne répond qu’à un risque beaucoup plus hypothétique et s’avère être un projet beaucoup plus lourd (il faudra prévoir des tables, des bureaux pour les gens se reconnectent).

Le software-defined storage répond également à certains besoins d’hyper-convergence

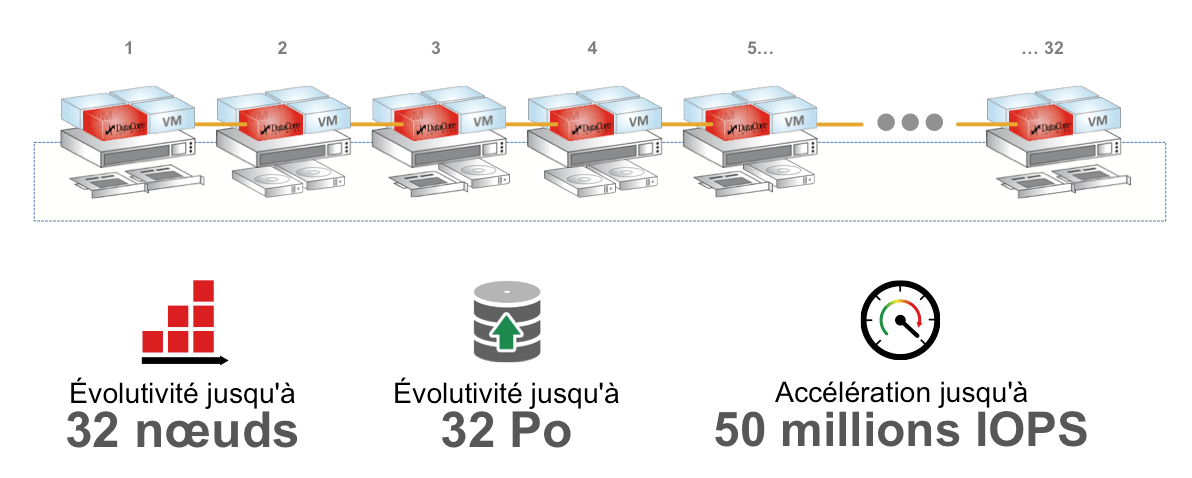

DataCore est de plus en plus sollicité pour des projets d’une nouvelle nature. Il s’agit de raccourcir la distance entre les applications et leurs données. Ce qui peut aboutir sur un besoin d’hyperconvergence pour rassembler dans la même ‘boite’ la charge applicative virtualisée, ses données et les traitements. On ne vise alors qu’à construire une informatique par silo applicatif, par thème -la comptabilité, les ventes, le métier, etc. DataCore propose de placer une VM dédiée DataCore sur chaque hyperviseur (Figure ci-dessous) et on construit en fait un stockage transverse répliqué sur tous les hyperviseurs : indispensable en cas de déplacement d’une VM applicative, ou d’un arrêt de service volontaire ou involontaire. C’est le mode de licensing V-SAN de DataCore Pour aller plus loin

Articles similaires

RES ONE Service Store offre aux employés une interface unique, accessible depuis les équipements de bureau et mobiles, qui leur permet d'obtenir tous...

Lire l'article

Imaginez donner la flexibilité à votre client de faire évoluer son stockage selon ses besoins, tout en réduisant le coût total de possession (TCO) ?...

Lire l'article

En 2015, Cactus, concepteur de mémoire Flash industrielle, a publié une série d'articles sur son blog (liens détaillés plus bas) couvrant la...

Lire l'article